Wir innovieren nicht – wir vergessen nur langsamer.

über

Im Eifer, gestrige Ideen mit dem Branding von heute neu zu verpacken, haben wir die Freude daran verloren, wirklich zu verstehen, wie Dinge funktionieren.

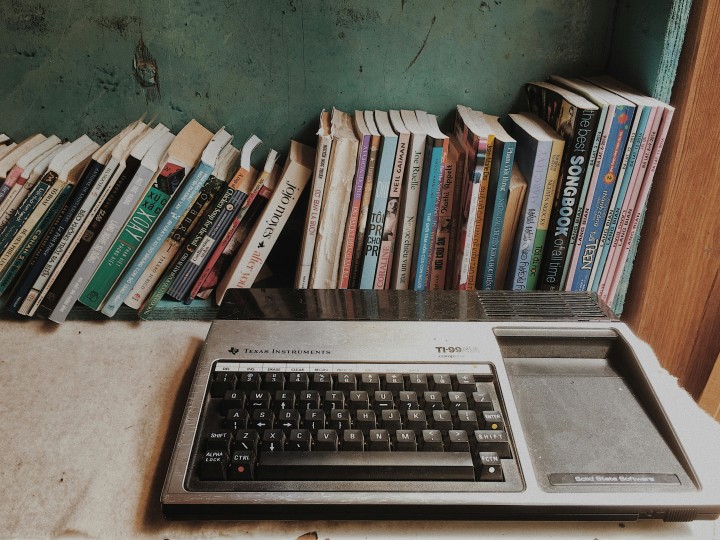

Mein Heimcomputer TI-99/4A von Texas Instruments startet noch immer. 41 Jahre nachdem ich ihn erstmals an den Holzdekor-Fernseher unserer Familie angeschlossen habe, fährt er in weniger als zwei Sekunden hoch – bereit, Befehle in TI BASIC entgegenzunehmen. Keine Updates. Keine Cloud-Anbindung. Keine Abogebühren. Keine Werbung. Einfach reine, deterministische Rechenleistung, die exakt das tut, was man ihr aufträgt – jedes einzelne Mal.

Mein Google Nest Wi-Fi-Router hingegen kann seit einem „hilfreichen“ Update meines Internetanbieters keine PPPoE-Verbindung mehr über mein Glasfasermodem aufbauen. Meine PCs können das allerdings noch – also habe ich das Modem direkt mit dem PC verbunden. Das bedeutet: kein Google Nest Wi-Fi. Und damit: all die smarten Glühbirnen im Haus? Derzeit funktionslos. Mein Fehler – ich weiß.

Das ist keine nostalgische Verklärung, sondern die nüchterne Feststellung, dass wir Zuverlässigkeit und Verständnis gegen die Illusion von Fortschritt eingetauscht haben. Der heutige Innovationszyklus gleicht einer kollektiven Amnesie: Alle paar Jahre entdecken wir Grundprinzipien neu, verpassen ihnen ein schickes Akronym und tun so, als hätten wir das Rechnen revolutioniert. Edge Computing? Das ist nichts anderes als verteilte Verarbeitung mit besserem Marketing. Microservices? Willkommen zurück im modularen Programmieren – jetzt mit 300 % mehr YAML-Dateien. Serverless? Gratulation, Sie haben das Timesharing wiederentdeckt – diesmal wird sekundengenau abgerechnet.

Der Test der Zeit

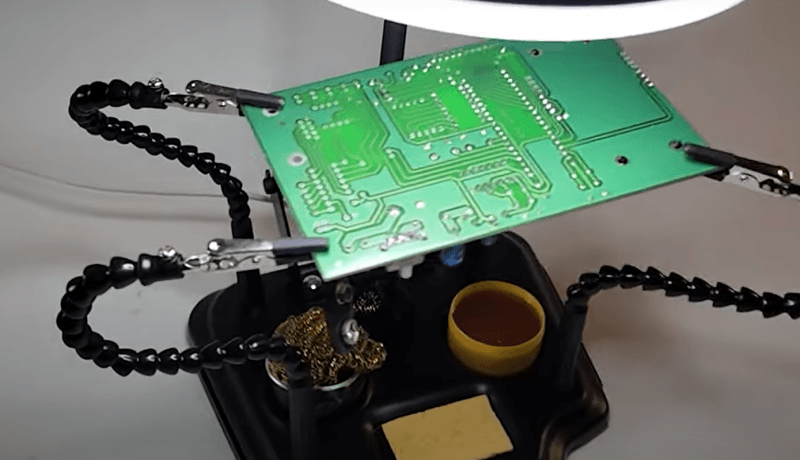

Es hat etwas zutiefst Respektgebietendes, ein 40 Jahre altes Elektronikgerät zu öffnen – und darin Bauteile zu finden, die man tatsächlich erkennt: Widerstände, Kondensatoren, integrierte Schaltungen mit aufgedruckten Typennummern, die man im Datenblatt nachschlagen kann. Ganz anders bei heutigen Black-Box-System-on-Chip-Designs: Ein einziger Defekt, und das komplette Gerät wird zu Elektroschrott. Wir haben auf maximale Fertigungseffizienz und geplante Obsoleszenz hingetrimmt – und dabei die radikale Idee aufgegeben, dass Anwender ihre Werkzeuge verstehen oder – Gott bewahre – sogar reparieren wollen könnten.

Mein VHS-Player im Keller ließ sich mit einem Schraubenzieher und einem Servicehandbuch (gelegentlich ergänzt um ein Oszilloskop) wieder flottmachen. Mein Wi-Fi-Router hingegen verlangt nach einem Doktortitel in Reverse Engineering, nur um herauszufinden, warum er keine Internetverbindung mehr aufbaut. (Googles auf Einsteiger getrimmte Benutzeroberfläche hilft wenig – sie sagt im Wesentlichen nur: „Ein Fehler ist aufgetreten.“) Wir verwechseln Komplexität mit Raffinesse – und Abstraktion mit Fortschritt.

Es geht dabei nicht nur um Hardware. Auch die Software hat denselben Weg eingeschlagen – eine Abstraktionsschicht auf die nächste gestapelt, bis ein derart fragiles Geflecht an Abhängigkeiten entstanden ist, dass das Update eines einzigen Pakets eine ganze Anwendung zum Einsturz bringen kann. Moderne Entwickler debuggen sich durch siebzehn Framework-Ebenen, nur um herauszufinden, dass das Problem ein fehlendes Semikolon in einer Konfigurationsdatei ist – generiert von einem Tool, das ein anderes Tool abstrahiert, das einst entwickelt wurde, um einen vor zwanzig Jahren noch völlig unkomplizierten Prozess zu vereinfachen.

Die KI-Hype-Maschine

Nichts verdeutlicht unser Vergessensproblem so sehr wie der aktuelle KI-Diskurs. Große Sprachmodelle sind beeindruckende statistische Textprädiktoren – zweifellos nützliche Werkzeuge, die bei Mustererkennung und Interpolation brillieren. Doch hört man dem atemlosen Enthusiasmus mancher Tech-Journalisten zu – die den Unterschied zwischen RAM und Festplattenspeicher nicht erklären könnten, selbst wenn ihre Klickzahlen davon abhingen – könnte man meinen, im Serverrack sei gerade das Bewusstsein erwacht.

Ausgerechnet die Medien, die „disruptive KI“ ohne jeden Anflug von Ironie verwenden, müssen bei jedem Artikel über maschinelles Lernen erst googeln, was ein neuronales Netz ist. Jeder noch so kleine statistische Fortschritt wird zur atemlosen Menschheitsverkündung aufgeblasen – dabei übersehen sie völlig, dass hier lediglich jahrzehntealte mathematische Verfahren mit mehr Rechenleistung zum Einsatz kommen. Es ist keine Magie, sondern lineare Algebra im Großmaßstab.

Wäre das nur Marketing-Getöse, könnte man es ignorieren. Doch das Missverständnis hat reale Folgen. Unternehmen setzen Milliarden auf Technologien, die sie nicht verstehen, während seriöse Forscher kaum noch zwischen echtem Fortschritt und VC-getriebenen Wunschvorstellungen unterscheiden können. Wir gehen in einem Rauschen unter, erzeugt von Menschen, die Begriffe kennen, aber die dahinterliegenden Prinzipien nicht begreifen.

Maker-Kultur vs. Dinge wirklich bauen

Die sogenannte „Maker-Movement“ ist ein weiteres Opfer unseres kollektiven Vergessens geworden. Was einst als ernstzunehmende Rückbesinnung auf praxisnahes Ingenieurdenken begann, wurde von der Influencer-Kultur vereinnahmt – wo das Ziel nicht mehr darin besteht, etwas Nützliches zu bauen, sondern Content darüber zu produzieren, wie man etwas Fotogenes baut. Ein Blick auf Maker-TikTok zeigt unzählige Videos, in denen Menschen LEDs auf Obst kleben und das als „innovatives Hardware-Hacking“ bezeichnen – während sie die eigentliche Ingenieurskunst, die in Laboren und Werkstätten weltweit stattfindet, vollkommen übersehen.

Echtes Bauen ist chaotisch. Es bedeutet, Materialeigenschaften zu verstehen, thermische Verhalten zu berücksichtigen, Ausfallmechanismen zu kennen – und tausend kleine Entscheidungen zu treffen, die einen funktionierenden Prototypen von einem teuren Briefbeschwerer unterscheiden. Es erfordert das Studium von Datenblättern, das Berechnen von Toleranzen und das Debuggen von Problemen, für die es keine Antworten auf Stack Overflow gibt. All das lässt sich weder gut fotografieren noch in ein 60-Sekunden-Videoformat pressen.

Die oberflächliche Variante der Maker-Kultur behandelt Ingenieurskunst wie eine Lifestyle-Marke – sie bedient sich der ästhetischen Anmutung technischer Kompetenz, ohne die Jahre intensiven Lernens, die nötig sind, um sie wirklich zu erlangen. Es ist eine Art Cosplay für Menschen, die innovativ wirken wollen, ohne sich mit der unglamourösen Realität des Verstehens auseinandersetzen zu müssen.

Das Wissensleck

Wir bilden eine Generation von Entwicklern und Ingenieuren aus, die Werkzeuge brillant bedienen können, aber nicht mehr wissen, wie diese Werkzeuge funktionieren. Sie können Anwendungen auf Kubernetes-Cluster deployen, aber keine einfache OpAmp-Schaltung entwerfen. Sie trainieren neuronale Netze, tun sich aber mit elementarer Statistik schwer. Sie entwickeln responsive Webanwendungen, haben aber nie Assembler gesehen oder verstanden, was genau zwischen dem Drücken der Eingabetaste und der Ausgabe auf dem Bildschirm geschieht.

Daran trifft sie keine Schuld – das Problem ist strukturelle Natur. Bildungssysteme und Industrie belohnen Breite statt Tiefe und Vertrautheit statt echter Beherrschung. Der Fokus liegt auf schneller Feature-Auslieferung statt auf fundiertem Systemverständnis. Das Ergebnis ist eine Art technisch erlernter Hilflosigkeit: Fachleute sind zunehmend abhängig von Abstraktionen, in die sie nicht mehr hineinblicken können.

Wenn diese Abstraktionen dann – wie es früher oder später passiert – versagen, stehen wir vor Systemen, die wir nie wirklich verstanden haben. Die Fehlermeldungen, falls überhaupt vorhanden, wirken wie in Hieroglyphen verfasst, weil uns das nötige Kontextwissen fehlt, um sie sinnvoll zu interpretieren.

Was wir jetzt brauchen

Wir brauchen Redakteure, die wissen, was ein Bode-Diagramm ist. Wir brauchen technische Fachtexte, die Intelligenz voraussetzen – nicht Unwissen. Wir brauchen Bildung, die Prinzipien ebenso vermittelt wie Werkzeuge, Theorie ebenso wie Praxis. Und vor allem: Wir müssen aufhören, Neuheit mit Innovation und Komplexität mit Fortschritt zu verwechseln.

Die besten Ingenieurlösungen sind oft bestechend einfach. Sie funktionieren zuverlässig, versagen auf nachvollziehbare Weise und können von den Menschen verstanden werden, die sie nutzen. Sie benötigen keine ständigen Updates, keine Cloud-Anbindung und keine Abo-Modelle. Sie tun einfach, was sie sollen – Jahr für Jahr.

Der TI-99/4A startet heute noch, weil er von Menschen entwickelt wurde, die jedes Bauteil, jede Schaltung, jede Codezeile verstanden haben. Er funktioniert, weil er zum Funktionieren gebaut wurde – nicht zur Umsatzmaximierung, nicht zur Datenerfassung und nicht als Plattform für ein komplexes SaaS-Geschäftsmodell.

Früher haben wir Dinge gebaut, die Bestand hatten. Wir können das wieder tun. Aber dafür müssen wir aufhören zu vergessen, was wir längst wissen.

Der Autor verbrachte während des Schreibens dieses Texts fünfzehn Minuten damit, seine smarte Türklingel ins WLAN zu bringen. Die Ironie ist ihm nicht entgangen.

Diskussion (0 Kommentare)