The Machine: Computer mit 160 Terabyte Einheitsspeicher

23. Mai 2017

über

über

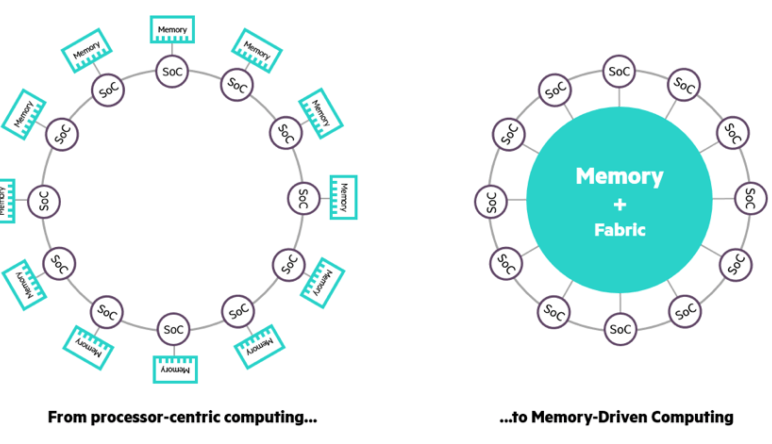

Auch wenn Computer immer schneller werden, können sie doch nicht mit dem enormen Wachstum an Daten mithalten, die wir produzieren. Der Grund hierfür ist, dass Computer auf einem Prinzip basieren, das schon gut 60 Jahre auf dem Buckel hat. In dieser Architektur ist der Prozessor das zentrale Element und Speicher spielt die zweite Geige. Um die damit verbundenen Probleme zu umgehen, haben Forscher von HP jetzt das Peradigma des Memory Driven Computing ausgerufen.

Beim Memory Driven Computing ist der Speicher das zentrale Element und der Prozessor tritt in die zweite Reihe. Die Idee dahinter ist, einen großen Speicher-Pool zwischen vielen Prozessoren zu teilen. Die Forscher von HP haben jetzt einen ersten Prototypen eines solchen Computers vorgestellt, den sie anspruchsvoll „The Machine“ getauft haben. Schon im November 2016 hatten sie eine Version mit insgesamt 160 TB Speicher angekündigt. Doch hier ist noch nicht Schluss: Es wird über fantastilliardische 4.096 Yottabyte (1024 Byte) nachgedacht, was dem 250.000-fachen des gesamten aktuellen digitalen Kosmos entsprechen würde. Bei The Machine handelt es sich um das größte je bei HP angegangene Projekt.

Beim Memory Driven Computing ist der Speicher das zentrale Element und der Prozessor tritt in die zweite Reihe. Die Idee dahinter ist, einen großen Speicher-Pool zwischen vielen Prozessoren zu teilen. Die Forscher von HP haben jetzt einen ersten Prototypen eines solchen Computers vorgestellt, den sie anspruchsvoll „The Machine“ getauft haben. Schon im November 2016 hatten sie eine Version mit insgesamt 160 TB Speicher angekündigt. Doch hier ist noch nicht Schluss: Es wird über fantastilliardische 4.096 Yottabyte (1024 Byte) nachgedacht, was dem 250.000-fachen des gesamten aktuellen digitalen Kosmos entsprechen würde. Bei The Machine handelt es sich um das größte je bei HP angegangene Projekt.

Mehr anzeigen

Weniger anzeigen

Diskussion (0 Kommentare)