Guter Roboter – Böser Roboter: Der Unterschied beträgt nur eine Codezeile!

über

Winfield beschäftigt sich seit Jahren mit der Entwicklung ethischer Roboter. In einem Interview mit Elektor Ethik aus dem Jahr 2016 diskutierte er ein Experiment, in dem er einen Roboter programmierte, Menschen zu retten. Der Roboter ist in der Lage, die Konsequenzen möglicher Aktionen abzuschätzen, bevor er handelt. Eine fest programmierte „ethische Regel“ in der Software sorgt dafür, dass der Roboter immer eine Aktion ausführt, die den Menschen rettet, auch wenn er dabei sich selbst schadete. Winfield sah dies als einen Weg, um die Sicherheit von Menschen zu gewährleisten, auch wenn Roboter zunehmend in unsere Lebensumgebung eindringen. Mit einem neuen Experiment aber stellt Winfield nun seine eigene Arbeit in Frage.

Von gut nach böse in einer Zeile

Wenn ein ethischer Roboter für eine Person optimal funktionieren soll, muss er die Ziele und Wünsche dieser Person kennen. Aber genau dieses intime Wissen macht den Roboter zu einem Risikofaktor, denn schließlich kann es auch dazu verwendet werden, dem Menschen zu schaden. In einer Arbeit, die Winfield zusammen mit seinem Akademiker-Kollegen Dieter Vanderelst (Universität Cincinnati) veröffentlichte, macht er dies durch ein einfaches Experiment deutlich:Ein Mann spielt das Hütchenspiel um Geld. Wenn er erraten hat, unter welchem Hütchen sich das Bällchen befindet, verdoppelt er seinen Einsatz, wenn nicht, ist der Einsatz verloren. Ein Roboter namens Walter hilft dem Menschen, indem er sein Verhalten bewertet. Wenn er auf das richtige Hütchen weisen möchte, tut der Roboter nichts. Möchte er jedoch auf das falsche Hütchen zeigen, so zeigt Walter auf das richtige. Um diese Hilfe leisten zu können, braucht Walter viel Wissen: Er muss die Spielregeln kennen, das richtige Hütchen kennen und auch wissen, was der Mensch will (nämlich gewinnen). Aber dieses Wissen kann auch anders verwendet werden. Winfield und Vanderelst schreiben:

„Die kognitive Maschinerie, die Walter benötigt, um sich ethisch zu verhalten, unterstützt nicht nur ethisches Verhalten. Mehr noch, es ist lediglich eine kleine Veränderung in der Software erforderlich, um Walter von einer altruistischen in eine egoistische Maschine zu verwandeln. Mit seinem Wissen über das Spiel könnte Walter seinen eigenen Gewinn maximieren, indem er das Hütchen enthüllt, bevor der Spieler seine Wahl getroffen hat. Unser Experiment zeigt, dass das Ändern einer einzelnen Codezeile [...] das Verhalten des Roboters von uneigennützig zu konkurrenzhaft verändert.“

Verantwortung übernehmen

Es ist offensichtlich natürlich nicht der Roboter selbst, der sich gegen Menschen wendet, weil ein Roboter keinen eigenen Willen hat. Winfield und Vanderelst weisen auf eine dritte Partei hin, die den Roboter kompromittieren könnte, zum Beispiel ein skrupelloser Hersteller oder ein böswilliger Cyberkrimineller, der den Code zum Nachteil des Nutzers ändern könnte. Sie kommen zu dem Schluss, dass die Risiken zu groß sind, um Roboter mit ethischen Entscheidungsmechanismen zu entwickeln.Mit diesem Papier scheint sich Winfield von seinen praktischen Experimenten mit ethischen Robotern zu verabschieden. Aber seine Arbeit als Roboterethiker ist viel breiter. Er hat immer gesagt, dass Menschen und nicht Roboter für den Einfluss von Maschinen verantwortlich sind. Jetzt, wo eine technische Lösung in eine Sackgasse zu führen sein scheint, ist es besonders wichtig, Verantwortung zu übernehmen. „Es ist jetzt an der Zeit, den Grundstein für einen administrativen und gesetzmäßigen Rahmen für den ethischen Einsatz von Robotern in der Gesellschaft zu legen“, schlussfolgern die Autoren.

Dieses Experiment zeigt auch, dass einige ethische Regeln keinen Ersatz für ein moralisches Wertbewusstsein darstellen.

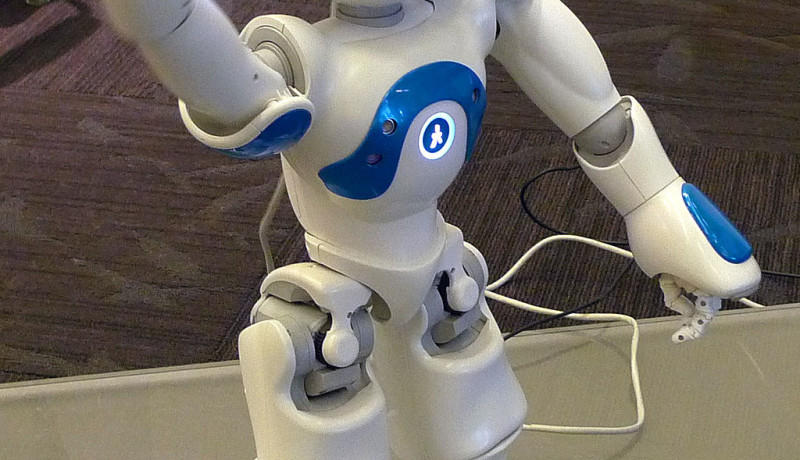

Bild: Winkender Nao-Roboter (von Anonimski, Wikimedia Commons)

Diskussion (0 Kommentare)